Alerte changement d’ère avec les “Agents IA”

De l’automate programmable au système auto-modifiant : un changement d’ère !

L’agent IA n’est pas un chatbot amélioré

L’agent IA n’est pas un chatbot amélioré

Depuis quelques mois, un glissement sémantique – et surtout conceptuel – est en train de passer largement sous les radars des décideurs : nous ne parlons plus d’IA « outil », ni même d’IA « assistant », mais d’agents.

👉 Des agents capables de définir un but, de choisir des moyens, de mobiliser des ressources,

👉 Des agents capables de dialoguer entre eux, de se répartir le travail, de s’auto-corriger, voire de s’auto-modifier.

La vraie question n’est donc plus « que peut faire l’IA ? » mais bien :

À qui confiez-vous votre carte Visa algorithmique ?

Qui est votre tiers de confiance dans un monde d’agents qui agit dans notre monde physique ?

et en sous jacent, avons nous changé d’ère et faut-il revoir notre référentiel ?

Pour nous aider à décoder, nous utilisons la méthode de veille InnoCherche avec notre Référentiel partagé qui regroupe des Convictions fortes … que nous devons modifier comme maintenant quand un élément nouveau (les agents IA) intervient. Aussi nous aimons tirer des analogies en termes d’usages avec des expériences d’usages antérieures comme:

- la photocopieuse connectée pour anticiper les problèmes du monde connecté promis par l’IOT

- et ici les robots programmés de Trading Haute Fréquence (HFT ou THF) pour comprendre le risque de hacking1 par les agents. Source : Référentiel InnoCherche – février 2024 – https://innocherche.com/blog/

1. Comprendre les agents IA : retour aux fondamentaux (sans hype)

Un agent, ce n’est pas magique. C’est un triptyque très classique :

- Un but (objectif à atteindre)

- Des moyens (outils, appels API, prompts, modèles)

- Des ressources (temps, données, budget, accès)

👉 Exactement comme… un robot de trading haute fréquence (HFT) … mais lui était programmé dans un langage explicable et auditable … alors que les agents IA ne le sont pas !

La nouveauté ? Ces agents ne vivent plus seuls. Ils opèrent :

- en réseau d’agents spécialisés,

- avec des patterns d’orchestration standardisés,

- dans notre monde physique i.e. dans un environnement ouvert, dynamique, non borné.

Conviction forte InnoCherche : “Nous sommes passés d’un monde compliqué à un monde complexe… où il y a trop d’interactions et surtout avec des lois non linéaires !”

Publication : Disruption digitale – Comment décoder et transposer, 2016 – ISBN 979-10-92928-48-8

2. Les catégories d’agents : une mécanique déjà industrielle

Pour sortir du flou, rappelons les principaux types d’agents, déjà à l’œuvre :

- Agent explorateur : va chercher de l’information ailleurs (≠ simple RAG)

- Planning pattern : gère des workflows dynamiques, déclenche des étapes

- Router pattern : analyse un prompt et choisit quel agent doit répondre

- Aggregator pattern : lance plusieurs agents en parallèle et synthétise

- Multi-agent pattern : un agent code, un autre teste, un troisième relit

- ReAct pattern : observe ses propres résultats et reboucle (raisonnement + action)

👉 À ce stade, l’agent peut être :

- soit un automate très sophistiqué,

- soit un chef d’orchestre AI entre agents

Rappel historique utile : HFT et AMF

Le High Frequency Trading nous a déjà fait le coup.

- Des algorithmes ultra-rapides

- Des chaînes de décisions automatisées

- Des effets systémiques non anticipés

👉 Résultat : un système très dur à contrôler et auditer ⇒ Selon le document Activités de l’Autorité – Focus 2024, l’Autorité des marchés financiers (AMF) indique une baisse du volume d’enquêtes en 2024, avec 30 enquêtes, 20 enquêtes supplémentaires à la demande d’autorités étrangères, 96 contrôles (dont 40 contrôles de masse et 30 contrôles SPOT) et 12 décisions de sanction. Le rapport annuel 2025 de l’AMF ne sera publié qu’en mai–juin 2026.

Le plus inquiétant ? Ces robots HFT “hackent le système” en plaçant, puis enlevant après quelques millisecondes, des faux “ordres limite” qui ne seront que très rarement exécutés, et ceci pour tester la réaction du marché et potentiellement le manipuler.

En effet, dans son rapport Trends, Risks and Vulnerabilities de 2024, l’ESMA (European Securities and Markets Authority ou Autorité européenne des marchés financiers) estime que le trading haute fréquence représente 60% à 80% des ordres (du fait du volume impressionnant d’annulations).

👉 Demain, les Agents AI feront encore mieux pour hacker le système et contourner toutes les règles IA mises en aval des LLM…et ceci de manière non auditable et encore moins contrôlable que le HFT.

3. Du monde fini au monde quasi infini

Avec les systèmes traditionnels de robots programmés (TFL, robots industriels, SI classiques) :

- Monde fini

- Langage auditable

- Comportements déterministes

Avec les agents IA :

- Monde quasi infini

- Comportements émergents et non contrôlables

- Auditabilité très faible

Conviction forte InnoCherche :

« Plus un système est autonome, plus la question de la gouvernance devient centrale. »

Livre On Peut Tout Réinventer, 2012 – https://innocherche.com/blog/

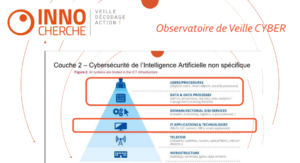

4. Cybersécurité : l’angle mort majeur des agents

Soyons clairs, comme nous l’avons dans un Observatoire de Veille Cyber l’année dernière 👉 Aucune des 6 couches actuelles de l’IA avec ses agents n’est réellement sécurisée.

Soyons clairs, comme nous l’avons dans un Observatoire de Veille Cyber l’année dernière 👉 Aucune des 6 couches actuelles de l’IA avec ses agents n’est réellement sécurisée.

Scénarios déjà observables :

- Injection de prompt dans un RAG → l’agent vous trompe

- Agent compromis → envoie de faux signaux

- Contournement des algorithmes de contrôle en sortie

- Attaque par saturation → équivalent DoS cognitif

Comme en HFT : l’agent conçu pour nous faire acheter au mieux … peut être hacké pour nous faire acheter au plus cher, sans que personne ne comprenne pourquoi.

Conviction forte InnoCherche : « La cybersécurité est un problème de management, pas de technologie. » Disruption digitale, 2016

5. Impact business : le retour brutal de la question du Tiers de Confiance

Un tiers de confiance, ce n’est pas un logo rassurant. C’est :

- une assurance de bonne fin,

- une responsabilité claire,

- une capacité de recours.

Question simple (et volontairement provocante) : À qui donneriez-vous votre carte Visa algorithmique ? Amazon ? Apple ? Microsoft ? Google ?… ou les nouveaux entrants OpenAI ? DeepSeek ? Perplexity ? Ali Express ? Temu ?

Aujourd’hui le risque d’agent hackant le système en by-passant les mesures de sauvegarde mises en aval des LLM n’est pas assurable. Donc la plateforme, l’hyper scaler, que vous choisirez peut-être, devra faire de l’auto-assurance pour vous donner une garantie de bonne fin … en développant donc ses propres agents, ceci afin de préserver son image de Tiers de Confiance.

Conviction forte InnoCherche :« Quand le risque n’est plus assurable, il devient stratégique. »

Livre Le digital a sauvé nos vies… qui va nous sauver du digital ?, 2021 – https://innocherche.com/blog/

6. Modifier la conviction : « pas de psychose …. »

On avait écrit dans notre référentiel : « Pas de psychose, jusqu’à présent on n’a jamais vu un ordinateur se reprogrammer tout seul. »

Aujourd’hui,avec des agents qui appellent d’autres agents, qui modifient leurs propres comportements, qui contournent les règles sans être programmés pour le faire … il est temps de modifier cette conviction de notre référentiel. Certes on n’est pas dans un système qui se “reprogramme” … mais dans un système qui s’auto-modifie et qui change son comportement sans que cela soit auditable ni contrôlable avec des chaînes d’agents impossibles à reconstituer après coup.

Conclusion – Oui nous changeons d’ère avec des agents IA non contrôlables manipulant des robots dans notre monde physique

Conviction forte InnoCherche : « Quand la complexité dépasse l’entendement humain, il faut ralentir pour comprendre. »

Ici, avec les agents qui ont montré leur capacité à contourner les barrières mises en aval des LLM (comme ici l’agent ChatBot de Chevrolet ayant vendu une Chevy Tahoe neuve pour 1$ “binding offer”) … la multiplicité d’arnaques et de tromperies est infinie. Donc, en plus du risque de hacking malveillant sur une architecture IA pratiquement non protégeable, il sera très difficile pour un Tiers de Confiance d’offrir la garantie de bonne fin indispensable à toute adoption.

1 hacking pris ici dans le sens “tordre le système pour lui faire faire autre chose que ce qu’il était conçu pour”